AI時代の信頼資本~誰も取り残さないデジタルセーフティ~

コンピューターユーザーは、自分の声に耳を傾け、温かみのある応答をし、理解しているように見えるシステムとの関わりを深めています。 Image: Freepik

Agustina Callegari

Initiatives Lead, Technology Governance, Safety and International Cooperation, World Economic Forum- 多くの人々がすでに日常的にデジタル技術を利用しており、チャットボットやアバターがオンライン上のやり取りをより個人的なものに感じさせてくれます。

- 一方、その急速な普及は一般の理解を上回るペースで進んでおり、特に子ども、労働者、高齢者、その他の脆弱な立場にある人々にとってリスクが生じています。

- AIをはじめとするデジタル技術への信頼は極めて重要であり、ステークホルダーは協力して、テクノロジーがユーザーを支配するのではなく、テクノロジーがユーザーのために機能する環境を整備しなければなりません。

私たちはすでに、ユーザーの声に耳を傾け、温かみのある応答をし、理解しているように見えるシステムと日常的にやり取りしています。音声アシスタントは忙しい一日の終わりに心を和ませ、チャットボットは課題の優先順位付けを行い、アバターはオンライン上のやり取りをより個人的なものに感じさせてくれます。

このような自然な対話形式は、情報へのアクセス障壁を下げ、学習を支援し、人的サービスが不足している場所でのケアを拡大する可能性を秘めています。ただし、これらは確率モデルに基づいて動作するものであり、実際の専門家の判断ではありません。また、その急速な普及は一般市民の理解を上回るペースで進んでおり、特に子ども、労働者、高齢者、その他の脆弱な立場にある人々にとってリスクが生じています。

信頼こそが核心的な課題です。デジタル技術への信頼とは、サイバーセキュリティなどの機械的要素と、是正可能性などの関係性要素が人々の期待とどのように組み合わさり、テクノロジーがユーザーのために機能することを保証できるかに関わるものです。ユーザーがテクノロジーに合わせるのではありません。

ユーザーがAIを信頼すべきでない場合とは

ほとんどのユーザーはAIに関する十分な経験を積んでいないため、何を信頼すべきか、またその理由について十分な理解を持っていません。自信に満ちた口調で応答するシステムは、ユーザーの受容を促します。これは些細なタスクでは有用ですが、医療、金融、法務サービス、精神的ウェルビーイング(幸福)といった重大な影響のある領域では、リスクを伴います。

最近の事例がこの緊急性を示しています。セラピストを装ったチャットボットが危険な助言を提供する、合成音声ツールが欺瞞的なソーシャルエンジニアリングを可能にする、採用アルゴリズムが昔の偏見を再現して適格な応募者を排除するなどの事例が出ているのです。こうした事例は、それぞれ偶発的に発生しているのではありません。一部の説得力あるインターフェースや不透明な設計選択が、大規模に人々の行動を変容させることができるという兆候です。

2023年11月のChatGPTリリース以降、AIの安全性に関する議論はそのアーキテクチャ、訓練データセット、理論的な故障モードなどの基礎モデルに焦点を当てており、実際に人々が使用する製品で生じる相互作用レベルのリスクは軽視されてきました。

一方、エンドユーザーを保護するためには、文脈依存型の危害要因に注意を向ける必要があります。具体的には、誤った信頼を醸成する説得的な口調、有害な行動を助長するユーザーインターフェース(UI)の初期設定、機密性の高い情報に対する脆弱性を露呈させるパーソナライゼーション、ユーザーがタイムリーな人的支援を受けられないエスカレーションギャップなどです。

初期段階のガイダンスによると、これらのシグナルは過度な依存を抑制し、検証行動を促進する効果があるとされています。来歴の表示、信頼度スコア、「この応答はAIによって生成されました」といったメッセージは、ユーザーに一度立ち止まっての確認、裏付けの精査、エスカレーションを促し、盲目的な依存を情報に基づいた利用へと転換します。

安全性の鍵となる相互作用重視の対策

これらの対策は必要ですが、単独では不十分です。デジタルセーフティの核心には、相互作用に焦点を当てた施策が据えられなければなりません。政策立案者や製品開発チームにとってこれは、製品設計、ガバナンス、教育、セクター横断的な対応を整合させ、AIとのやり取りに代表されるインテリジェントな相互作用が人々の生活やウェルビーイングに影響を与える前に、社会からの信頼を得られるようにすることを意味します。

製品機能は、特に孤独感やうつ病といった危機的状況下では、人々が必ずしも自己規制できるわけではないという現実を踏まえ、常に利用可能で友好的なAIが擬似的な信頼関係を増幅させる可能性を考慮する必要があります。

したがって、インターフェースには、擬人化を抑制し、誤った親密感や権威を減らすための行動規範となるガードレールを組み込む必要があります。初期設定で備えるべきその他の保護策としては、プライバシー最小化設定、機密領域におけるパーソナライゼーションの制限、来歴情報の明確化、不確実性シグナルの表示、危機的、臨床的、法的問い合わせに対する迅速な人間介在型エスカレーションなどが挙げられます。

企業は、相互作用による危害に焦点を当てた定期的なレッドチームテスト(攻撃者を模倣したテスト)を実施し、入力された機密性の高い情報の再利用を制限し、脅威モデルと是正計画を文書化した安全対策マニュアルを公開しなければなりません。

同時に、規制当局は高リスクな導入に対して独立した監査とアクセス可能な救済メカニズムの設置を義務付け、業界横断的な迅速対応ネットワークを構築して、プラットフォームや国境を越えたインシデント情報の共有と解決策の調整を行う必要があります。

これらの措置はイノベーションを阻害するものではなく、強力なツールが人々の生活やウェルビーイングに影響を与える前に、社会からの信頼を得られるようにするためのものです。アカウンタビリティを強化することにより、人々は安心して有益なAIツールを活用できるようになり、万が一問題が発生した場合にも適切な救済手段があることを知ることができるのです。

AIリテラシーとサポート体制の拡大の重要性

同様に重要なのは、AIリテラシーと地域に根差したサポートを拡大し、人々がAIを信頼すべき時と人間の助けを求めるべき時を判断できるようにすることです。教育プログラムは、大規模データセットに入力するプロンプトの生成技術(プロンプトクラフト)を教える以上に、人間の心理に基づいた教育を行い、あらゆる年齢層のユーザーが説得的なデザイン手法を認識し、データの来歴に関する手がかりを読み取り、重要な助言の真偽を検証する方法を学べるようにする必要があります。

図書館、学校、職場、地域センターなどでは、ロールプレイ研修や、ユーザーを信頼できる専門家に繋ぐ「エスカレーションマップ」を提供することができるでしょう。かつて学校がコンピューターの授業を行ったように、今こそAIをツールとして扱い、その仕組み、有用性、潜在的な危害について解説するAI授業を導入しなければなりません。

「デジタルセーフティ・グローバル・コアリション」はすでにこの課題を推進するための取り組みを推進。各国政府、企業、市民社会、技術専門家を結集し、AI技術コミュニティと企業、信頼性、安全性の専門家の間に存在するギャップを解消すると同時に、AIとユーザーの相互作用について議論を深めています。

スイスのダボスで開催される世界経済フォーラム年次総会2026では、こうした議論を中核に据えると同時に、コンテンツの信頼性確保、オンライン安全規制の整備、そしてあらゆる地域コミュニティで安全を確保することができるようになる、スケーラブルなデジタルリテラシープログラムの改善に焦点を当てます。

安全性を優先することができれば、AIとのやり取りは包摂性、創造性、そしてレジリエンスを促進する力となり得ます。来歴の明確化と不確実性シグナル、機密領域における慎重な初期設定、広範なリテラシーの普及、透明性の高い安全対策、そして国際的な連携によって、 そうした未来を実現することができるでしょう。

政策決定者と製品開発チームにとって喫緊の課題は、製品ライフサイクル全体に相互作用に対する安全対策を組み込むこと、リスクの高い領域に導入する際には独立した責任体制を義務付けること、そしてユーザーがAIツールを安心して活用することができ、問題発生時にも適切な対応が取れるよう、コミュニティ中心型のリテラシー向上に投資することです。

このトピックに関する最新情報をお見逃しなく

無料アカウントを作成し、パーソナライズされたコンテンツコレクション(最新の出版物や分析が掲載)にアクセスしてください。

ライセンスと転載

世界経済フォーラムの記事は、Creative Commons Attribution-NonCommercial-NoDerivatives 4.0 International Public Licenseに基づき、利用規約に従って転載することができます。

この記事は著者の意見を反映したものであり、世界経済フォーラムの主張によるものではありません。

最新の情報をお届けします:

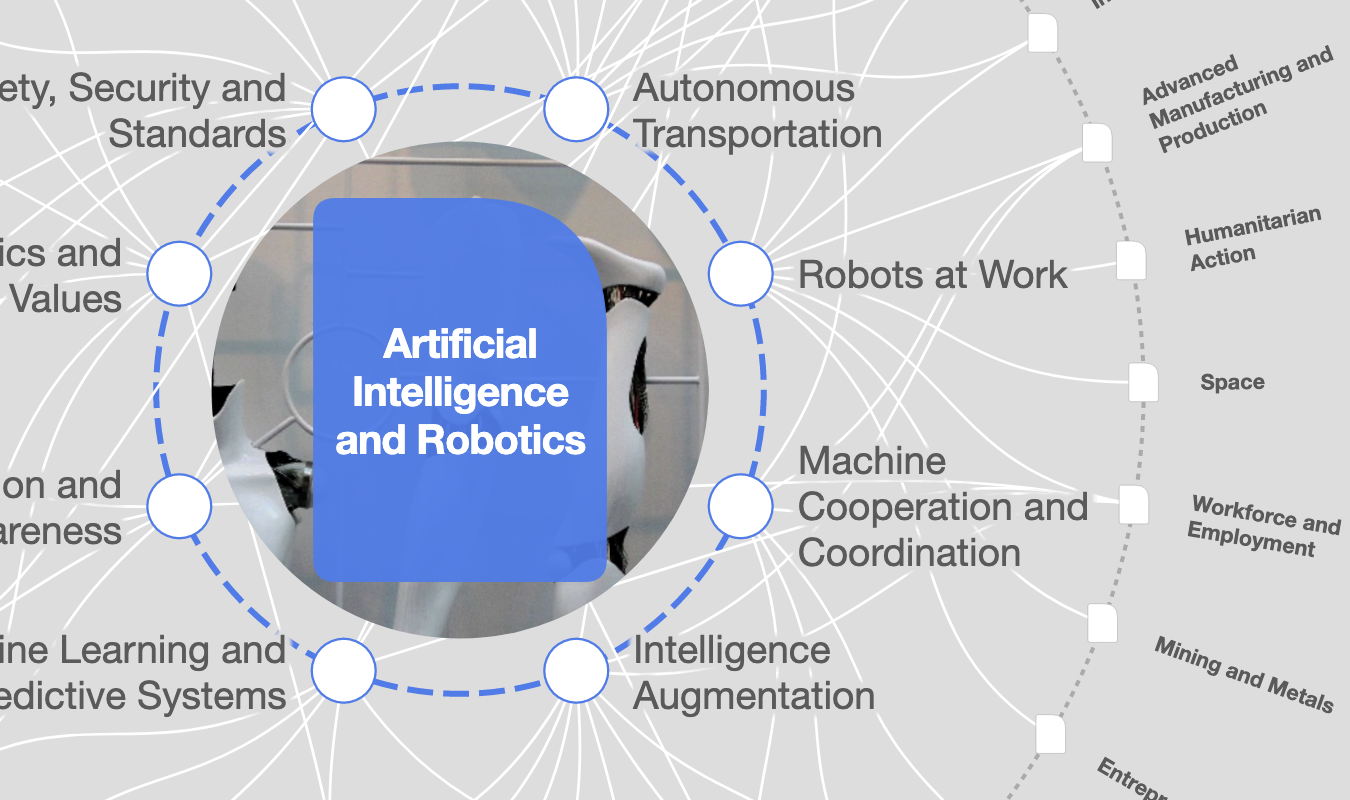

AIとロボティクス

「フォーラム・ストーリー」ニュースレター ウィークリー

世界の課題を読み解くインサイトと分析を、毎週配信。