ChatGPTに聞く、生成AIのリスク管理

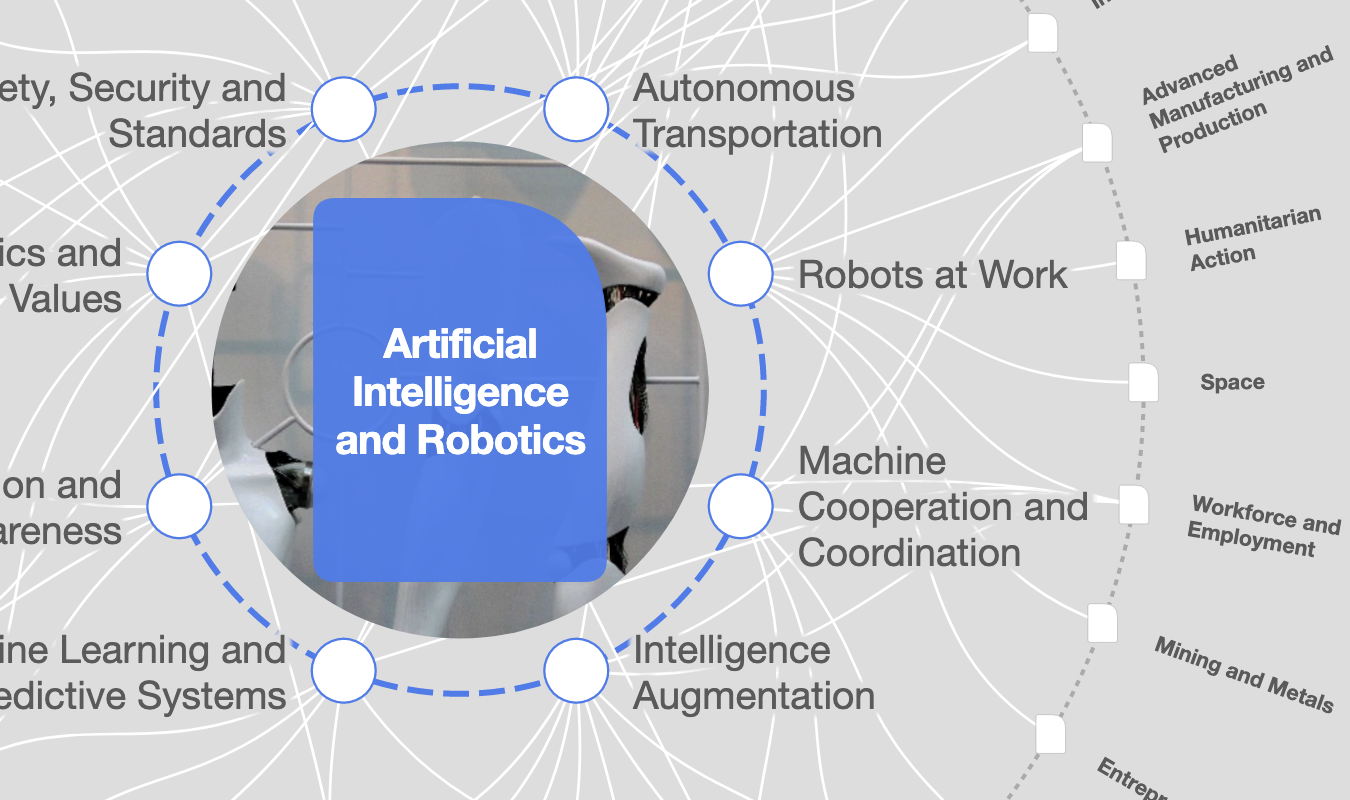

生成AIは、私たちの働き方に革命を起こす可能性を秘めていますが、ChatGPTはこのことについてどのように語るでしょうか。 Image: Unsplash/Rolf van Root

Keri Pearlson

Executive Director, Cybersecurity, MIT Sloan Research Consortium, MIT - Sloan School of Management- 生成AIは労働者の効率性と創造性を高める可能性を秘めていますが、一部の役割で人間に取って代わることも期待されています。

- AIは業務効率を高め、市場動向を予測し、新たなイノベーションを生み出しますが、同時にビジネスリスクももたらします。

- オンラインツールであるChatGPTに、生成AIの一般的な使い方とリスクについて尋ねてみることにしました。

生成AI(人工知能)は、私たちの働き方を根本的に変える可能性を秘めています。労働者が、より効率的で創造的になるのを助けるようになると期待されている一方で、労働者に取って代わるのではないかとも考えられています。

インドのスタートアップDukaan社は、AIチャットボットの導入後、サポートスタッフの90%を解雇しました。このツールは顧客からの問い合わせに即座に対応し、人間のスタッフの働きを大幅に上回ったのです。導入は簡単ではなかったものの、顧客の問題解決にかかる時間は98%短縮され、カスタマーサポートのコストは85%削減されました。

同じ頃、サムスンのエンジニアたちは、ChatGPTを使用してエラーをチェックし、自社のコードを最適化していました。システム設計を強化する新しいツールが見つかったと考えたのですが、実際には、報道で大騒ぎになったように思わぬ影響に悩まされることになりました。

ツールはコードを最適化しただけでなく、そのコードがシステムのトレーニングに使用され、外部に漏れてしまったからです。ChatGPTや他の生成AIシステムは極めて有用な洞察や提案を提供しますが、その利用に伴う新たなリスクを理解する必要があります。

AIは業務効率を高め、市場動向を予測し、新たなイノベーションを生み出し、一見つながりのないアイデアからつながりを見出すなど、多くのことを可能にします。これらの新しいツールは、設計、評価、生成、管理、保護、開発など、私たちがAIに求めるあらゆる作業に革命を起こしています。

しかし同時に、これらのシステムは新たなビジネスリスクを生み出してもいます。私たちは、ChatGPTに人気のある使い方とリスクについて尋ねてみることにしました。

もちろん、ChatGPTのような大規模な言語モデルには「幻覚」を見る傾向があり、ユーザーはそのようなシステムができること、できないことの限界を理解する必要があります。

生成AIの最も人気のあるユースケース

私たちは、最も人気のあるユースケースは何だろうと考え、ChatGPTに尋ねました。

「生成AIの最も人気のあるユースケースは何ですか?」

ChatGPTは、クリエイティブ・アプリケーション、コンテンツ生成、デザインとプロトタイピング、データ増強、パーソナライゼーション、レコメンデーション、バーチャル・アシスタント、ビデオゲーム開発、科学研究、シミュレーション、トレーニング、ストーリーテリングと物語生成を取り上げて、それぞれの利用方法について詳しく説明してくれました。

そして、最後にこう結論付けています。

「生成AIは、様々な領域で幅広い用途があります。これらのカテゴリは、生成AIの顕著な用途のいくつかを表していますが、この分野は急速に進化しており、新しい用途が生まれ続けています」。

私たちは、このリストが時間の経過とともに変化するだろうと考えています。

生成AIを利用するリスク

人気のあるユースケースがわかると、リスクについても知りたくなりました。生成AIには大きな可能性がありますが、深刻なビジネスリスクや管理すべき課題もあります。そこで、ChatGPTにこのように尋ねました。

「生成AIを利用するリスクは何ですか?」

ChatGPTは次のようなリスクを挙げました。

- 誤報やフェイクコンテンツ

- プライバシーとデータ保護

- 倫理的な意味合い

- 偏見と差別

- 知的財産の侵害

- セキュリティの脆弱性

- 意図しない結果

ChatGPTは続けて次のように述べました。

「これらのリスクを軽減するためには、強固なセキュリティ対策を実施し、倫理的なガイドラインを遵守し、透明性が高く説明責任を果たせるAIを実装し、生成AIシステムの影響を継続的に監視・評価することが極めて重要です。また、そのリスクに対応するために、生成AIに対する一般の認識と理解を促進することも不可欠です」。

生成AIはどのように悪用されるのか

私たちは、悪意を持ったユーザーが生成AIを使用した場合の新しい攻撃ベクトルを理解することに非常に興味がありました。私たちがChatGPTを良い用途に使うことができるなら、悪意ある者が悪用することもできるからです。

そこで、私たちはChatGPTに「悪意のある行為者はどのように生成AIを利用するでしょうか?」と尋ねました。

その答えはこうでした。

「残念ながら、あらゆる優れたテクノロジーがそうであるように、生成AIも、悪意のある行為者によって様々な目的で悪用される可能性があります。」

以下は、ChatGPTが教えてくれた、生成AIが悪用される可能性のある例です。

- ディープフェイク

- フィッシング攻撃

- スパム生成

- フェイクニュースや偽情報

- 個人情報の窃盗

- 自動化された攻撃

- ソーシャル・エンジニアリング

興味深いことに、このテクノロジーを使用した有害なコードの生成、プログラムの破壊、マルウェアの設計、その他の侵略的な脅威ベクトルの作成などは省かれていました。

生成AIのリスクを減らすには

生成AIに関連するリスクを減らすために、人間は重要な役割を果たすことができ、ChatGPTは、リスクを減らす方法についていくつかの提案をしています。

ChatGPTによると、これらの戦略をとる目的は、リスクを軽減し、テクノロジーの倫理的な展開を促進すること。

提案された戦略は次のとおりです。

- 強固なデータガバナンス

- 倫理的なフレームワークとガイドライン

- 偏見の緩和

- 対抗的攻撃に対する防御

- 透明性と説明可能性

- 定期的なモニタリングと評価

- 従業員の教育と意識向上

- コラボレーションと業界標準

生成AIの活用から得られた洞察

ChatGPTは、その能力とリスクについてよく理解しており、一般的な利用方法を簡単に説明できました。また、潜在的なリスクを特定し、今日のテクノロジーの利用に伴う倫理的およびセキュリティ上の課題を強調しています。

このテクノロジーは問い合わせのすべてに迅速に対応し、そのスピードには目を見張るものがあります。しかし、その回答は一般的なもので、詳細には欠けていました。ただ、私たちが気付いたのは、回答をもとにより深い調査ができるだろうということ。たとえば、リスクに関する質問に続けて「偏見がリスクであるとはどういう意味ですか?」といったフォローアップの質問をすることで、さらに掘り下げた回答を得ることができます。

生成AIの真のパワーは、クエリが具体的であればあるほど、より詳細な情報を提供できることにあると言えるでしょう。フォローアップの質問をしたり、より詳細な説明を求めたりすることで、生成AIはより具体的で詳細な、ニュアンスの異なる情報を提供してくれます。

このように質問と回答を繰り返すことで、回答の深みが増し、生成AIは学習と発見のための強力なツールとなるのです。

ChatGPTの回答は洞察に富んでいましたが、それはシステムの訓練に使われた情報に基づいています。つまり、システムが学習するにつれて回答が変化する可能性があるということです。さらに、トレーニングデータが不十分であったり、偏っていたりすると、回答が正確でなくなる可能性があります。

仕事で利用する際は、生成AIシステムの結果をそのまま信じないよう警告されています。応答を鵜呑みにするのではなく、AIが生成した洞察を人間の専門知識で補い、回答を検証し、最適な行動のセットを得るために複数の異なる方法で質問をすべきです。

しかし、全体的に見ると、生成AIは思慮深い事例と実践的なアドバイスを提供するという点で、素晴らしいパフォーマンスを発揮することがわかりました。インターフェイスの簡単さ、レスポンスの速さ、回答の詳細さは特に印象的でした。私たちのニーズには合っているため、今後も活用するつもりです。

このトピックに関する最新情報をお見逃しなく

無料アカウントを作成し、パーソナライズされたコンテンツコレクション(最新の出版物や分析が掲載)にアクセスしてください。

ライセンスと転載

世界経済フォーラムの記事は、Creative Commons Attribution-NonCommercial-NoDerivatives 4.0 International Public Licenseに基づき、利用規約に従って転載することができます。

この記事は著者の意見を反映したものであり、世界経済フォーラムの主張によるものではありません。

最新の情報をお届けします:

Generative Artificial Intelligence

アジェンダ ウィークリー

世界の課題を読み解くインサイトと分析を、毎週配信。