責任あるAIの大規模展開に向けた5つのステップガイド

『責任あるAI』を推進する組織になるための抜本的な変革に企業が取り組まない限り、AIを大規模に展開していくには問題があります Image: shutterstock/metamorworks

- 「責任あるAI(人工知能)」を推進する組織になるための抜本的な変革に企業が取り組まない限り、AIの大規模な展開には課題が残ります。

- AIシステムへの信頼が、ビジネスを行う価値のある相手を判断するにあたり決定的な要素となるため、企業はこの変革を受け入れる必要があります。

- 本記事では、企業に向けた責任あるAIの大規模な実現に向けた手引きを紹介します。

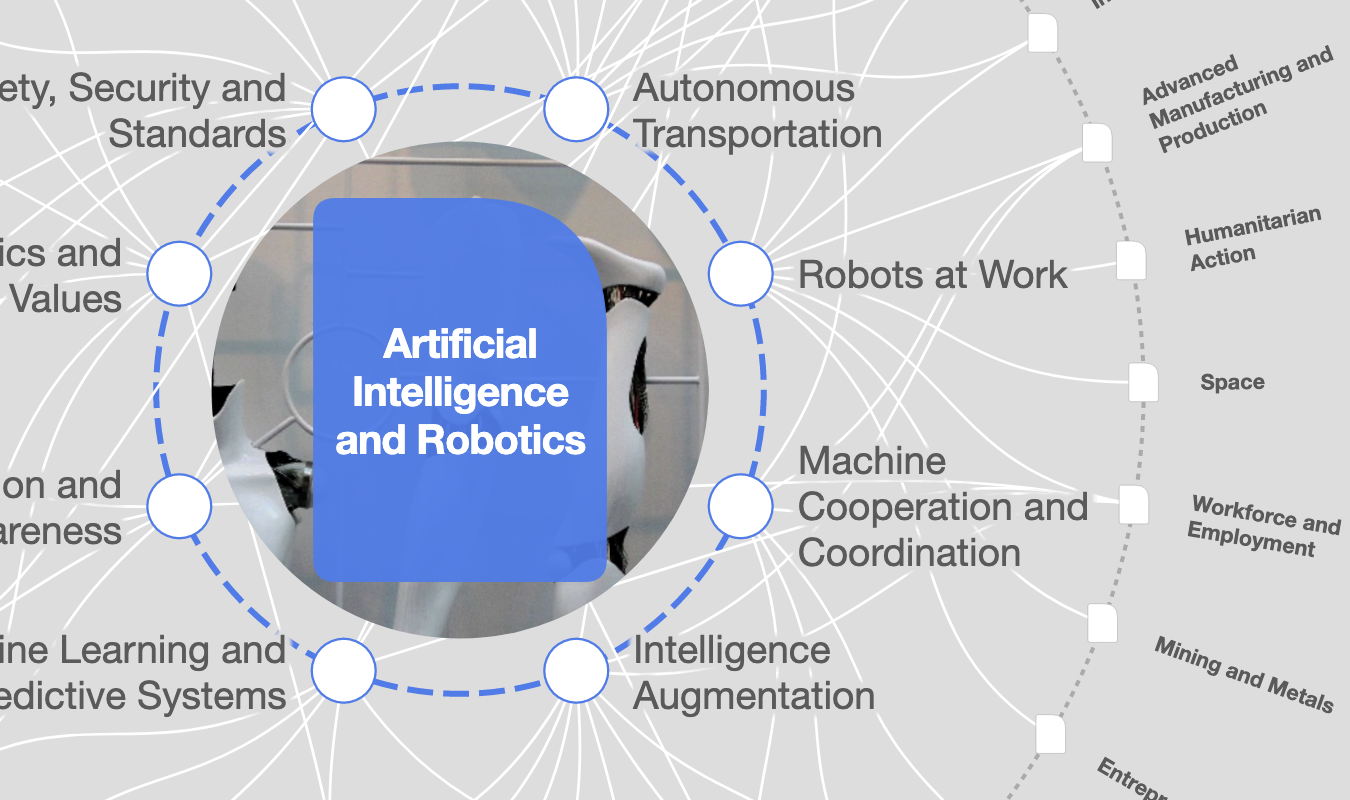

機械学習は、企業の運営方法を抜本的に破壊し始めた革命的なテクノロジーです。マッキンゼー・アンド・カンパニーのグローバルAI調査で報告されているように、企業が自社のビジネスプロセスに機械学習を導入しようと躍起になっているのは驚くことではありません。その一方で、AIの大規模な展開に成功しているのはごく一部に過ぎません。AIの非倫理的な使用が定期的に報告され、その弊害に対する社会的関心が高まっていることをふまえると、大規模展開のプロセスを達成することは容易ではないと考えられます。

企業が「責任あるAI」を推進する組織へ変革することを目指し、抜本的な取り組みに着手するまで、このような問題は続く可能性が高いでしょう。取り組みを進めるにあたり求められるのは、AI関連のガバナンス課題に対処し、適切な戦略を策定・実行することです。

企業が責任あるAIを大規模に展開していくために必要となるステップとは?ここでは、鍵となる5つの要素を紹介します。

AIが生み出す独自のガバナンス課題

不確実性に満ちた世界に生きている私たちが、明確にプログラム化されていないデータのパターンやつながりを発見することにより、この基本的な現実にある程度対応できる学習システムを構築できるというのは、大きなチャンスと捉えることができるでしょう。

しかし、機械学習には独自のガバナンス上の課題があるため、依然として懸念事項も残ります。まず、これらのシステムはデータへの依存度が高いことから、企業は個人データを大量に収集することとなり、その過程でプライバシーの問題が発生する可能性があります。

そして、高品質なデータの収集、クリーニング、処理はコストがかかる複雑な作業となるため、企業のデータセットは「現実世界」を正確に反映していないことが多いのです。反映されている場合でも、人間のバイアスを単に再現したり、悪化させたりすることがあるため、差別的な結果につながる恐れがあります。それは、データに埋め込まれた本質的な傾向がAIのフィードバックループによって増幅される可能性が高いためです。

さらに、個人の詳細な行動情報を取り込むことで、従来では見られないほど高精度の個別ターゲティングが可能になるため、無制限のストレージ能力を持つ大規模な計算システムの力によって匿名性という選択肢が排除されてしまいます。

より根本的なレベルでは、AIを搭載したシステムはデータと使用状況に応じて進化するため、その動作を予測することが困難であり、誤動作が発生するとデバッグやメンテナンスが難しくなります。従来のソフトウェアとは異なり、システムに与えた指示を単純に修正するだけでは、本来意図した機能との整合性を取り戻すことはできません。簡単に言うと、何か問題が生じたときに、その原因を究明し是正措置を講じることが難しいのです。この意味で、収益の最大化といった純粋な目的であっても、高度な機能を備えたAI学習システムがユーザーを欺いて追加の支出をさせる、深くて検出しにくい方法を開発してしまうなどという可能性があるので、当然のことながら倫理的な懸念が生じています。

責任あるAIを大規模に展開していくための5つのステップ

企業は、上述のようなリスクを軽減しつつ、AIの大規模展開を成功させるにはどうすればよいのでしょうか。責任あるAIを推進する企業になるためには、抜本的な組織改革を行う必要があります。その変化を誘導するための出発点として、以下のプロセスを提示します。

1. 責任あるAIが自社にとって何を意味するかを定義する:組織全体が同じ方向に向かっていることを確認するために、経営者は部署を超えて役員、経営幹部、上級管理職が参加する協同プロセスを通じて、自社にとって「責任あるAIの使用」とは何かを定義する必要があります。これは、AIサービスや製品の設計と使用の指針となる一連の原則といった形式でもいいでしょう。このような原則の起草プロセスは、AIが組織にとってどのような価値を生み出すことができるのか、また、そのプロセスでどのようなリスク(ブランドの評判、従業員の安全、顧客にとって不公平な結果、公共の場面の発言における二極化の増加など)を軽減する必要があるのかについて、実践的な検討を中心に据え、構築していく必要があります。

グーグルやマイクロソフトなどの主要な業界関係者はすでにこの方向に進んでおり、責任あるAIの原則を発表しています。より多くの企業がこうした例に従うべきでしょう。このような原則を起草することには主に2つの利点があります。ひとつ目は、トップマネジメントをはじめとするすべての人に、責任あるAIについて学ぶ機会が提供されること。二つ目は、これを基に責任あるAIビジネス戦略の基盤を形成し、責任あるAIサービスや製品の供給経路をどのように構築するかという自社の計画の詳細を明らかにすることができます。

2. 組織力を構築する:信頼できるAIシステムの設計と展開は組織全体で取り組むべきものです。責任あるAIの導入を推進するためには、適切な計画、部門横断的かつ協調的な計画の実行、従業員のトレーニング、そして、資源への多額の投資が必要です。企業は、これらの活動を試験的に実施するために、社内に「AIエクセレンスセンター」を設立し、トレーニングと導入の推進という2つ中核要素が機能するように注力すべきです。

従業員が実際の業務を遂行するためには、AIシステムと関わる状況下でリスクがどのように発現するかを理解し、さらに重要なこととして、それらのリスクを特定・報告・軽減する方法を理解することができるよう、訓練を受ける必要があります。どんなに善意の企業であっても、技術チームだけに焦点を当てていたのでは失敗する可能性があるのはこのためです。また、AIエクセレンスセンターは、信頼できるAIソリューションや製品の導入を監督するビジネスの「サポーター」と緊密に連携して運営していく必要があります。

3. 部門の枠を超えたコラボレーションを促進する:リスクは状況に大きく依存するものであり、業務機能が異なればリスク認識も変わってきます。戦略を立案する際には、様々な部門からの相補的な視点を持つことで適切なリスク優先順位付けのスキームを構築しましょう。

そうすることで、トップマネジメントの「盲点」を減らし、業務遂行中の従業員による強力なサポートを確保することができます。また、学習システムは予期せぬ行動を誘発する傾向があるため、システム運用中にも対処が必要となるリスクが発生します。ここでは、リスク担当者とコンプライアンス担当者の調整による緊密で部門横断的な連携が、効果的な改善策の設計と実行の鍵となります。

4. よりホリスティックなパフォーマンス指標を採用する:現在業界においては、AIシステムは通常、ベンチマークデータセットの平均的なパフォーマンスに基づいて評価されています。しかし、AIの実務者や研究者は、それがパフォーマンス評価に対して非常に狭いアプローチであることを認識しており、別の方法を積極的に調査しています。

私たちが提案するアプローチは、より包括的なものです。企業は、責任あるAIの原則に照らしてシステムの動作を定期的に監視・評価する必要があります。この観点から、組織が「責任あるAIを搭載したサービスや製品」とみなす定義に、システムの動作が一致していれば、 そのシステムは高性能であるとみなされます。

5. 責任の所在を明らかにする:適切なトレーニングやリソースを用意していても、説明責任を正しく果たすことができなければ、永続的な変化を実現することはできません。言い換えれば、正しいことをするためには、従業員に正当なインセンティブを与え、従業員が正しいことをすることで評価されるようにしなければなりません。これは、責任あるAIの実務者たちが報告している最大の課題の1つです。この課題に対し、提案したい解決策は2つ。

まず、AI製品の発売前レビューの一環として、あるいはそれとは別に、倫理的な配慮がなされているかどうか確認するための審査プロセスを導入することです。この審査プロセスでは、関係する各チームの役割と責任をマッピングした組織的な枠組みと、例えば製品管理者とプライバシー管理者との間で、意見の相違が続いた場合などに従うべき段階的な手順を、明確にする必要があります。次に、問題のあるユースケースを報告し、時間をかけて是正措置を導入した従業員には、毎年の業績評価の一環として報酬を与えること。

今後の展望

この革新的なテクノロジーを有益かつ信頼できる形で活用するためには、AIに対する責任あるアプローチが必要であるという認識が、ビジネスリーダーの間で高まっています。しかし、現状では、企業価値を創出しながらAIを大規模に導入していくにはどうしたらよいのかが明確になっていません。私たちは、それが可能であることを確信していますが、実現には大幅な組織変革が必要です。

人生における重要な変化を迎える時と同じように、最初の一歩はたいてい難しいものです。ビジネスリーダーたちが移行フェーズの歩みを進める際に、この手引きが役立つことを願っています。長期的に見れば、責任あるAIを推進する企業が最も競争力のある企業となる可能性が高いため、粘り強く取り組むことを推奨します。実際、AIシステムへの信頼の必要性はトレンドではなく、ビジネスを行う価値のある相手を決定づける重要な要素なのです。

このトピックに関する最新情報をお見逃しなく

無料アカウントを作成し、パーソナライズされたコンテンツコレクション(最新の出版物や分析が掲載)にアクセスしてください。

ライセンスと転載

世界経済フォーラムの記事は、Creative Commons Attribution-NonCommercial-NoDerivatives 4.0 International Public Licenseに基づき、利用規約に従って転載することができます。

この記事は著者の意見を反映したものであり、世界経済フォーラムの主張によるものではありません。

最新の情報をお届けします:

ビッグデータ

関連トピック:

アジェンダ ウィークリー

世界の課題を読み解くインサイトと分析を、毎週配信。