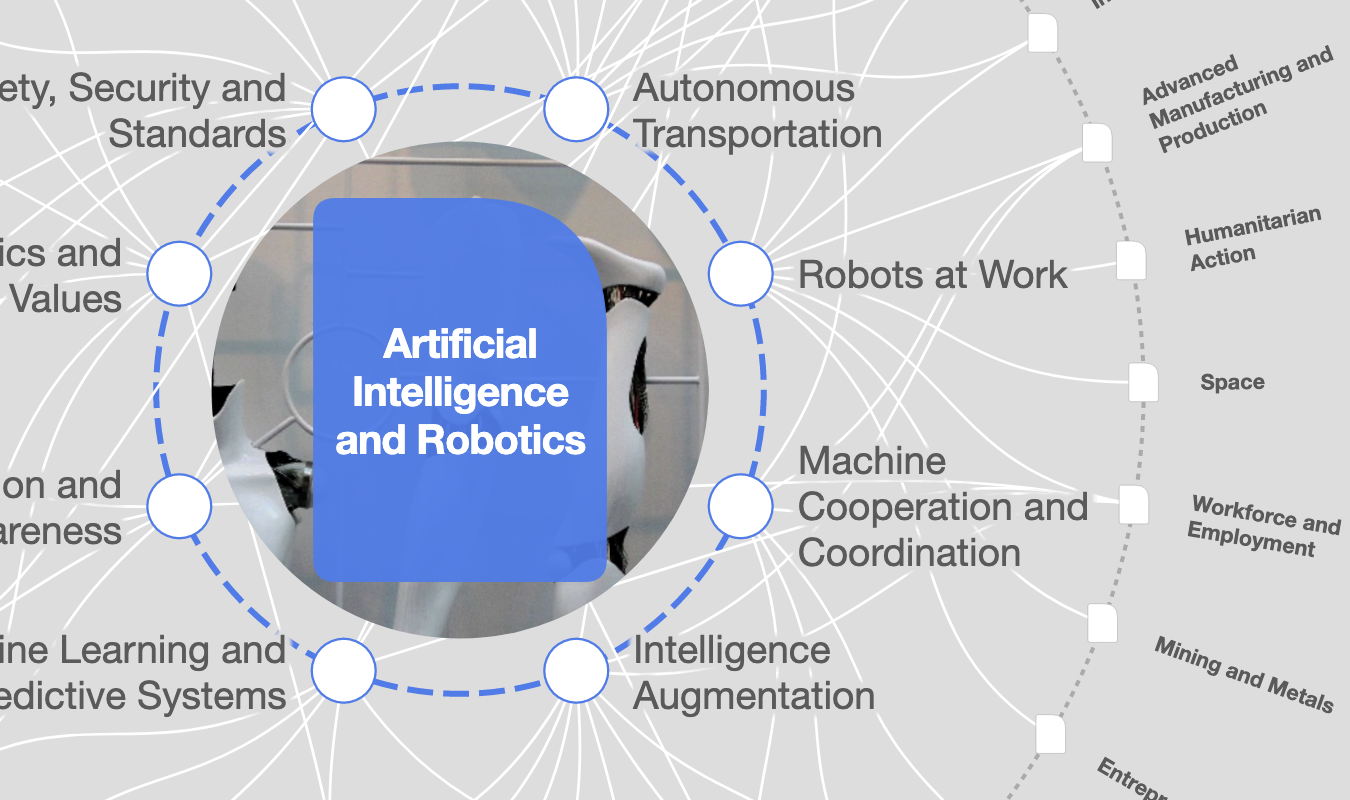

人工知能に倫理は必要。その倫理とは?

認知機能を持つ機械が、慎重に考慮すべき複数の倫理的問題を提起する Image: 画像:ロイター

Srikar Reddy

Managing Director and Chief Executive Officer, Sonata Software Limited and Sonata Information Technology LimitedMauro F. Guillén

Zandman Professor of International Management, The Wharton School, University of Pennsylvania, USA自動運転車やアルゴリズム取引、臨床判断支援システム、そしてデータマイニングなど、さまざまな場面で使われる人工知能(AI)のカギを握るのは、ビッグデータと機械学習。AIの発展には大容量データの利用が不可欠な条件です。そのため、デジタルプラットフォームとツールが、かつてない規模で利用される中国の巨大な人口とビジネスセクターは、AIの恩恵を受けるでしょう。また、デジタル世界にユーザーが残す行動痕跡から収集した情報に利用制限がないことも、大きな利点となります。またインドでは、生体認証トークンシステムの導入や、高額紙幣の廃止、物品・サービス税制度の統合など、国内経済のデジタル化が進められています。

一方で、フェイスブックやケンブリッジ・アナリティカの個人情報不正利用で倫理的配慮という問題が浮き彫りになりました。ただし、これは問題のほんの一部にすぎません。AIの利用には、機械学習の支援や我々の仕事を代行するための、かつてなく大容量のデータ処理が伴い、企業は情報の取り扱いにますます慎重になることが求められています。事故が幅広く報道されたテスラやウーバーは、自動運転車の開発事業を縮小しました。AIの利用には、どういった倫理と責任が伴うべきなのでしょうか。国際的な基準が存在しない中で、どのようにしてそうした責任意識を高めていくことができるのでしょうか。

現時点でAIとその技術の適用には明確な倫理規定がないため、企業はいかにそのリスクを回避するかを内外の利害関係者と検討するしかありません。

ここで、<義務論>と<目的論>で倫理基準を比較してみましょう。前者は意図と手段、後者は目的と結果が重要視されます。自動運転車の場合、環境にも配慮した無事故輸送システムが目的であれば、さまざまな運転状況を想定した大規模なデータ収集や、AIの実用試験は十分な正当性を持ちます。

対照的に、臨床的介入や臨床試験を目的論で正当化することはできません。忌まわしい人体実験の歴史を踏まえれば、企業やAI研究者は、むしろ意図や手段を根拠にした義務論の観点から、自分たちの活動の倫理性を判断することが妥当です。

他人から自分にしてもらいたいと思うような行為を人に対して行うことを説く、いわゆる黄金律も倫理の目安のひとつです。ただし、個人情報が収集・分析される側の人々と、潜在的に恩恵を受ける人々との間には意見の大きな隔たりがあるため、急成長するAI分野には容易に適用できません。つまり、データ収集の行為自体には黄金律を直接適用することはできないのです。

次に、<文化相対主義>と<普遍主義>の違いから倫理基準を検討してみましょう。前者は特定文化の価値観や規範、後者は相互に合意した基準が倫理的な行為の根拠になります。情報機密の考え方が欧州と米国で対立し、グーグルやフェイスブックといった企業の市場勢力図に影響を与えていることは、この比較から説明できるでしょう。中国やインドといった新興市場が掲げる基本理念は文化相対主義。技術立国としての発展を妨げる規制を回避することで有利な状況を確保しようとするものです。

1980年代以降の技術基準のように、倫理基準も世界の市場勢力図形成に重要な役割を担うでしょう。AIデータの利害とニーズがある以上、企業は活動や目的の詳細にまで倫理的責任が問われます。AIの利用がグローバル化する中で、我々は倫理が持つ役割に注目しています。経済界や社会の対応がデジタル社会でのAI利用を決定づけると言っても過言ではありません。

一方で、AIが倫理的な役割を果たすためには、予測可能性と信頼性という関連する2つの側面が重要になります。AIが対応できない説明責任やデータの使用許可等の複雑な問題に予め対処しておくことは、AI分野への投資促進につながるでしょう。AIの発展には、その技術や影響、データ利用に対する消費者の信頼も必要であり、この信頼を高めるのは予測可能で透明性のある対応です。

認知機能を持つ機械は思考、理解、学習、問題解決、そして意思決定といったこの高度なプロセスが実行可能です。AIを活用することで、人間の知能を補い、経済や政府の活動を発展させることが期待されます。

しかしながら、認知機能がありAIを備えた機械の開発には、倫理的な問題が伴います。「認知機能を持つ機械が独立して意思決定を行う意義はなにか」「そのような意志決定を許可するべきか」「AIの意思決定に対する最終責任者は誰か」「機械学習は制御し、規制し、監視するべきか」という問題です。

こうした問題は複雑で日々変化していくため、確固たる法的枠組みでの対応が必要ですが、政治や法律のみでは不十分です。信頼性を高めるためには、倫理規定も同様に重要なのです。

政府はAIの倫理について、あらゆる当事者を巻き込んで議論を進めていくべきです。民間セクターや消費者団体、学術界を巻き込むことで、技術的、社会的、そして政治的な発展に呼応した倫理規定を策定することができるでしょう。

また、政府は既存の取組みと連携してAIの倫理を研究し、議論していかなければいけません。そのようなイニシアチブは多く存在します。例えば、アラン・チューリング研究所、未来のインテリジェンスのためのレバーヒューム・センター、世界経済フォーラム第四次産業革命センター、王立協会、「人々と社会に貢献する人工知能のためのパートナーシップ」が進めるイニシアチブです。

ただし、こうしたイニシアチブにも倫理的問題が伴います。

意思決定及び責任:AIの利用が増えると、意思決定の責任分配がより困難に。誤った決定が損害を招く場合、誰がそのリスクを請け負うべきでしょうか。

透明性:複雑な機械学習システムを使用して重要な意思決定を行う場合、特定の行動に潜む問題の原因を解きほぐすことは困難となることも。説明責任を果たすためには、機械が出す推論に対して明確な説明が必要です。

偏見:機械学習システムは、意思決定システムの既存傾向を優先する可能性もあり、AIが中立的に発展できるような配慮が必要です。

人間の価値観:AIシステムはプログラミングにより価値観や「常識」が設定されます。ロボットとロボティックス・システムの倫理的なデザインと応用に関する英国規格協会の規格BS8611は、「ロボットは人間を殺すか、傷つけることを単一のもしくは主要な目的として設計されるべきではない。ロボットではなく、人間がその責任主体である。すべてのロボットとその行動について、責任者を見つけることができるようにするべきである」と定めています。

データ保護と知的財産:AIの潜在性は、大容量データセットへのアクセスが決め手になります。単一のデータセットでAIシステムを構築後、そのシステムで新しいデータセットを学習させるとどうなるでしょうか。

責任能力のあるAIは、道徳的原則や倫理的価値に配慮し、人間の基本的な倫理観と矛盾しないかを確認します。AIを非倫理的に使用した企業への申し立てが行われる中、アマゾン、グーグル、フェイスブック、IBM、マイクロソフトは、人工知能技術のベストプラクティスの創出、市民の理解推進、人工知能に関するプラットフォーム機能を目的とした非営利パートナーシップを形成しています。

このトピックに関する最新情報をお見逃しなく

無料アカウントを作成し、パーソナライズされたコンテンツコレクション(最新の出版物や分析が掲載)にアクセスしてください。

ライセンスと転載

世界経済フォーラムの記事は、Creative Commons Attribution-NonCommercial-NoDerivatives 4.0 International Public Licenseに基づき、利用規約に従って転載することができます。

この記事は著者の意見を反映したものであり、世界経済フォーラムの主張によるものではありません。

最新の情報をお届けします:

AIとロボティクス

「フォーラム・ストーリー」ニュースレター ウィークリー

世界の課題を読み解くインサイトと分析を、毎週配信。

もっと知る 新興テクノロジーすべて見る

Naoko Tochibayashi

2025年11月14日